Neue iPhone-Features: Apple Personal Voice & Live Speech

Im Rahmen des Welttags der Barrierefreiheit hat Apple zahlreiche Neuerungen bei iPhone und iPad für beeinträchtigte Menschen enthüllt. So sollen Anwender etwa ein Sprachmodell auf Basis der eigenen Stimme erstellen können. Durch das Mobilgerät ist man dann dazu in der Lage, trotz Einschränkung weiterhin mit den Mitmenschen verbal zu kommunizieren.

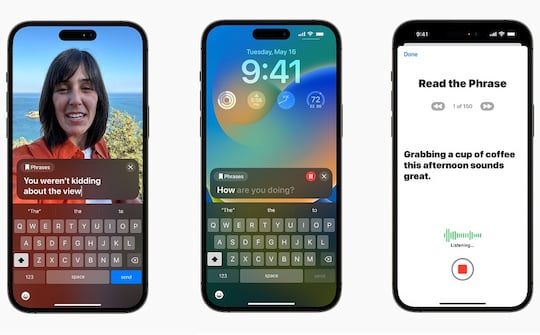

Neben dieser Personal Voice getauften Funktion wird es auch Live Speech geben. Hierbei tippen User Texte während Telefonaten ein, welche als Sprache ausgegeben werden. Point and Speak kompensiert wiederum Sehbeschwerden durch das Vorlesen von Beschriftungen.

iPhone und iPad: Apple weitet Barrierefreiheit aus

Personal Voice und Live Speech in Aktion

Personal Voice und Live Speech in Aktion

Bild: Apple

Viele Bürger leiden unter physischen Einschränkungen. Die daraus resultierenden Alltagsprobleme lassen sich dank moderner Technologie zumindest teilweise reduzieren. Apple hat bereits häufig durch innovative Features in puncto Barrierefreiheit auf sich aufmerksam gemacht. Jetzt gibt es diesbezüglich Neuigkeiten. Via Pressemitteilung informiert der Hersteller über Personal Voice, Live Speech, Point and Speak sowie weitere Funktionen. Die Erweiterungen sollen noch dieses Jahr für Besitzer eines iPhones und iPads ausgerollt werden.

Personal Voice soll Menschen unterstützen, denen krankheitsbedingt, etwa durch Amyotrophe Lateralsklerose, der Verlust der Sprachfähigkeit bevorsteht. Außerdem gehören Nutzer mit anderen verbalen Komplikationen zur Zielgruppe. Maschinelles Lernen ermöglicht es, eine künstliche Stimme zu erzeugen, die wie die eigene klingt. Hierfür müssen Anwender Textphrasen für eine 15-minütige Audiodatei vorlesen, die als Basis des Sprachmodells dient. Das Resultat ist etwa für eine weitere Neuerung, Live Speech, nützlich. Über dieses Feature können bei Telefonaten Texteingaben in Sprache umgewandelt werden.

Point and Speak in Lupe für Sehbeeinträchtigte

Wenn es Probleme bei der visuellen Wahrnehmung gibt, kommt Point and Speek in Lupe ins Spiel. Das Feature liest Beschriftungen vor, beispielsweise auf Tasten von Haushaltsgeräten und Fernbedienungen. Apple realisiert diese Erweiterung anhand einer Kombination aus Kamera, LiDAR-Scanner und maschinellem Lernen.

Bewegt ein Anwender seinen Finger über eine Taste, analysiert Point and Speak in der Lupen-App bei iOS und iPadOS den Text. Anschließend wird die Beschriftung vorgelesen. Zu den weiteren Neuerungen zählt die Game-Controller-Funktion der Schaltersteuerung für User mit motorischer Beeinträchtigung.

Bei Apple Music und Karten gibt es indes neue Lifestyle-Features.